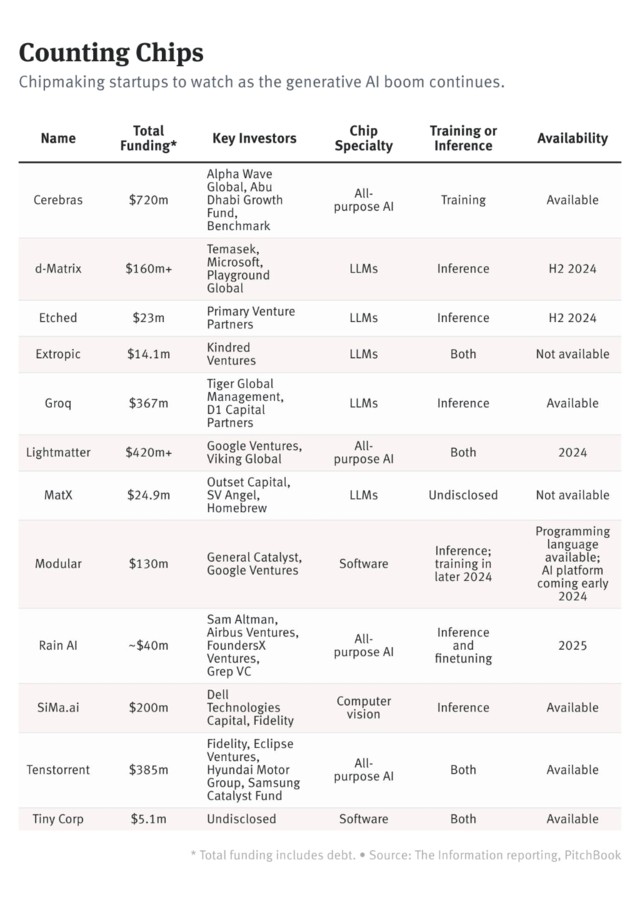

顛覆 GPU、打倒英偉達!深扒 12 家 AI 芯片獨角獸

中國媒體匯總了 12 家 AI 芯片獨角獸公司,它們是英偉達的有力挑戰者。其中一家公司 Cerebras 以製造巨型芯片聞名,已獲得 7 億美元的融資。雖然 Cerebras 在商業客户方面面臨挑戰,但該公司宣佈與美國梅奧診所合作,開發專有 AI 模型。這項協議被稱為價值數百萬美元的協議。其他公司的情況尚不清楚。

2024 開年,去年大漲的科技股一片慘跌,但引領 AI 浪潮的總龍頭英偉達依然勢頭不減。

沒有哪家芯片公司不眼紅英偉達的地位,隨着 AI 產業的蛋糕越做越大,硬件賽道也肉眼可見得擁擠起來。大量初創公司正試圖流向英偉達 GPU 的預算裏分一杯羹。

媒體匯總了目前處於競爭最前線的 12 家公司。這些初創企業平均歷史只有五年,融資額度最高的已有 7.2 億美元,它們都是英偉達的有力挑戰者。

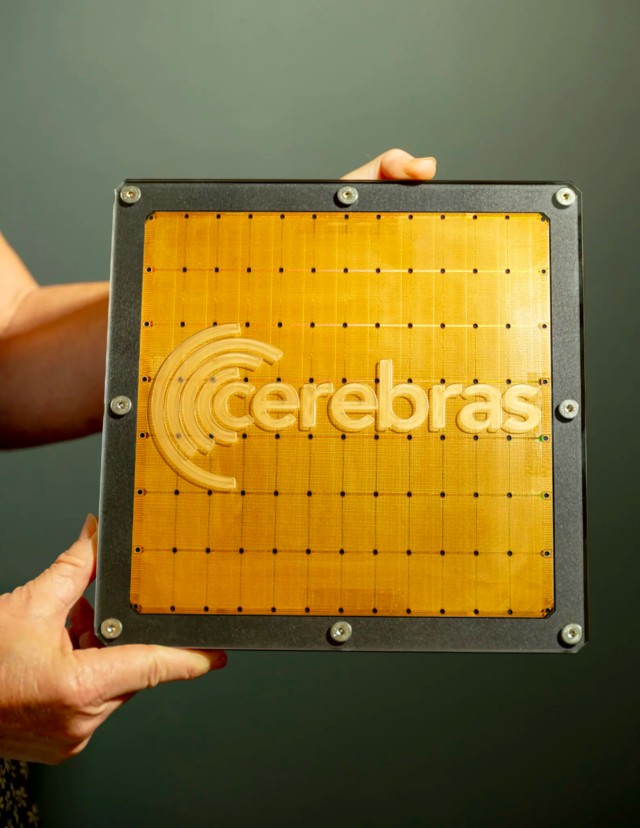

Cerebras

成立時間:2015

應用領域:訓練

Cerebras 以製造巨型芯片聞名。由 Gary Lauterbach 和 Andrew Feldman 聯合創立。兩人還曾經聯合創辦專注於超高密度計算機服務器業務的公司 Seammicro,在 2012 年被 AMD 以高達 3.57 億美元的價格收購。

Cerebras 的主要產品是可用於 AI 訓練的超級計算機芯片和系統,專為超級計算任務而構建,此類芯片的大小約為普通 GPU 的 56 倍。

Cerebras 的客户集中於國防、學術實驗室等機構。旗艦產品 CS-2 超算系統已經部署在美國能源部阿貢國家實驗室、匹茲堡超算中心、愛丁堡大學超算中心等地。

不過,雖然已經獲得高達 7 億美元的融資,但受制於英偉達 GPU 和 CUDA 生態的主導地位,Cerebras 在爭取商業客户方面面臨着艱鉅的挑戰。

1 月份,公司宣佈將與美國頂尖醫療機構梅奧診所合作,梅奧診所將使用 Cerebras 的計算芯片和軟件,以數十年的匿名醫療記錄和數據為基礎,開發專有 AI 模型。

據報道,一些模型將能夠讀寫文本,比如為新病人總結病歷中最重要的部分。其他模型可以分析複雜的醫學圖片或分析基因組數據。

Cerebras 首席執行官 Andrew Feldman 稱,這是一項為期數年、價值 “數百萬美元” 的協議。

d-Matrix

成立時間: 2019

應用領域:推理

創辦於 2019 年的 d-Matrix 正在開發一種專用芯片和軟件,用於運行機器學習模型,公司的芯片可以處理和內存結合在一起,而處理和內存通常是芯片上獨立和不同的組件。

d-Matrix 的芯片產生的熱量更少,因此需要的冷卻也更少,因此比主流的 GPU 和 CPU 芯片更具成本效益。公司 CEO 表示,許多公司都希望利用大模型設計 AI 應用,成本非常重要。

d-Matrix 選擇專注於推理,即運行 AI 模型,而非訓練。公司認為,隨着時間的推移,模型會越來越大,運行成本也會越來越高。公司已有客户在測試其芯片和軟件,並計劃在 24 年上半年將投入商用。

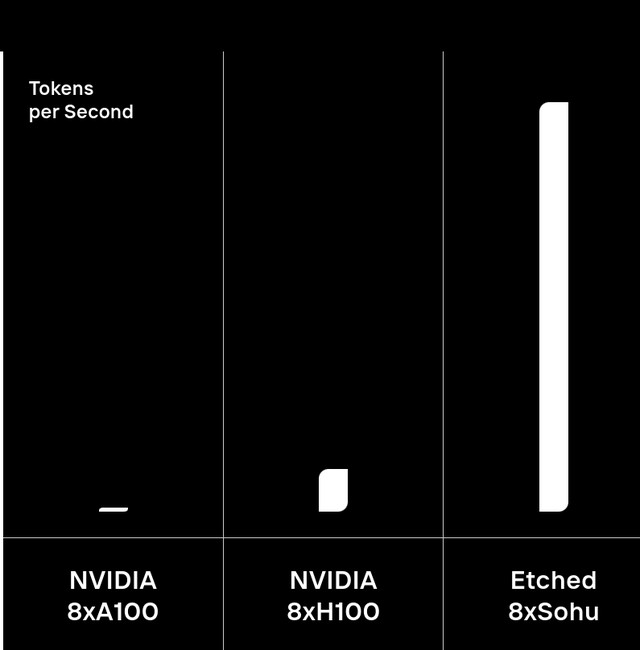

Etched

成立時間:2023

應用領域:推理

Etched 由兩位哈佛輟學生 Gavin Uberti 和 Chris Zhu 於去年 6 月創立,公司計劃生產一款名為 Sohu 的 AI 推理加速芯片,推理性能為 H100 的 10 倍。公司成立不久後估值即達到 3400 萬美元。

據報道,在製作工藝上,Sohu 採用將變壓器架構直接刻芯片核心的革命性方法。因此性能可以達到前所未有的高度,與傳統 GPU 相比,Sohu 在模擬中運行大模型的速度要快 140 倍。Sohu 還支持通過樹搜索更好地編碼,能夠並行比較數百個響應,同時還能進行多重推測解碼(Multicast speculative decoding),可以實時生成新的內容。

Etched 的博客稱,這種架構將允許以無與倫比的效率運行萬億參數模型。該系統只有一個內核,可容納完全開源的軟件堆棧,可擴展至 100T 參數模型。

Extropic

成立時間:2022

應用領域:推理&訓練

Extropic 是這幾家初創公司裏最神秘的那個。公司創始人出身谷歌專注前沿技術探索的 “登月工廠” 部門 “X”。據介紹,Extropic 專注於量子計算,同時計劃開發一款專門用於運行大模型的芯片,但目前仍未有任何關於具體產品的細節曝出。

去年年底,公司剛剛完成 1410 萬美元的種子輪融資。

根據公司的新聞稿,隨着生成式人工智能的興起,世界對可擴展、高成本效益和高效計算的需求急劇增加,Extropic 希望在未來,讓計算機把熵作為一種資產加以利用,通過編程自我學習,並以前所未有的效率運行:

Extropic 的計算範式建立在熱力學原理之上,旨在將生成式人工智能與世界的基本物理學無縫融合。我們的目標是將生成式人工智能最終嵌入物理過程,突破物理定律在空間、時間和能量方面規定的效率極限。

Groq

成立時間:2016

應用領域:推理

Graphcore 成立於 2016 年,總部位於英國布里斯托爾。公司主要產品的智能處理單元(LPU),且聚焦於大模型推理。

公司產品最大的特點就是極快的生成速度,可以確保流暢的終端體驗。在消費類 AIGC 應用中,用户對速度要求很高,而 Groq LPU 搭配開源模型 Meta Llama 2 70B 可以實現每秒生成 300 個單詞,在 7 分鐘內就能生成與莎士比亞的《哈姆雷特》相同數量的單詞,這比普通人的打字速度快 75 倍。

Groq 聯合創始人兼首席執行官 Jonathan Ross 認為,對於在產品中使用人工智能的公司來説,推理成本正在成為一個問題,因為隨着使用這些產品的客户數量增加,運行模型的成本也在迅速增加。與英偉達 GPU 相比,Groq LPU 集羣將為大模型推理提供更高的吞吐量、更低的延遲和更低的成本。

此外,受制於 HBM3 和 CoWoS 封裝的產能,英偉達 GPU 目前的產能無法完全滿足客户需求,而 Groq LPU 的獨特之處在於,它不依賴於三星或海力士的 HBM,也不依賴於台積電的 CoWoS 封裝技術,因此不會面臨類似英偉達那樣的產能瓶頸。

Lightmatter

成立時間:2017

應用領域:訓練&推理

Lightmatter 利用激光器發出的光在芯片和服務器羣之間傳輸數據,公司由麻省理工學院的學生利用該校的專利技術創立。

據公司聯合創始人兼首席執行官 Nicholas Harris 介紹,與英偉達、AMD 和英特爾等通過線纜傳輸數據的芯片廠商相比,Lightmatter 的產品可以讓數據中心的能耗成本降低約 80%。

MatX

成立時間:2022

應用領域:未公佈

MatX 由前谷歌員工創辦,首席執行官 Reiner Pope 為谷歌 Pathways 大模型的開發者之一,首席技術官 Mike Gunter 則是谷歌 TPU 的研發人員之一。

MatX 正在開發用於文本應用的 LLM 專用芯片。公司表示,與英偉達 GPU 硬件相比,其自研芯片的運行速度更快,成本更低,可支持包括圖像生成在內的多種人工智能應用。

MatX 稱,公司已經得到幾家風險投資公司的支持,但未披露具體的資金,還稱已得到 “著名大模型開發商的大力支持”,但也未披露具體公司。

Modular

成立時間:2022

應用領域::推理;今年開始涉足訓練

Modular 專注於打造用於訓練和運行大模型的開發平台和編碼語言,用户可在該平台上使用各類 AI 工具,包括谷歌開源軟件 TensorFlow 和 Meta 的開源軟件 PyTorch。

公司認為,AI 開發如今面臨受到過於複雜和分散的技術基礎設施的阻礙,Modulal 的使命是消除大規模構建和維護 AI 系統的複雜性。

構建和運行人工智能應用程序需要大量的計算能力,為控制成本,一家公司可能會使用不同類型的 AI 芯片,但這些芯片的軟件往往互不兼容。尤其是,英偉達用於編寫機器學習應用程序的 Cuda 軟件只能在自家芯片上運行,這基本上將開發者鎖定在其 GPU 上。Cuda 的用户粘性極強,有報道稱,一家計算機視覺初創公司花了兩年時間才得以改用非英偉達芯片。

Modular 希望通過開發一種 Cuda 替代方案來改變這種狀況,解決不同芯片的軟件兼容性問題,讓使用非英偉達芯片變得更容易。

Rain AI

成立時間:2017

應用領域:推理&微調

傳統 GPU 的訓練和推理過程需要消耗產生高昂成本,這部分成本部分源於這些芯片在從內存和處理部件傳輸數據時產生的熱量,因此,GPU 需要持續冷卻,從而增加了數據中心的電力成本。

而 Rain AI 的 NPU 芯片可以模擬人類的生物大腦,將內存和處理功能結合在一起,不僅在計算速度和能效方面表現出色,還可以根據周圍環境實時定製或微調人工智能模型。不過公司目前還沒有生產出成品。

據媒體報道,一份 2019 年簽訂的意向書顯示,OpenAI 計劃斥資 5100 萬美元購買 Rain AI NPU 芯片,這些芯片將被用於 GPT 模型的訓練和部署。

Sima.ai

成立時間:2018

應用領域:推理

Sima.ai 專注於為邊緣計算設備開發硬件和軟件,應用於飛機、無人機、汽車和醫療設備等場景,而非數據中心。

公司創始人 Krishna Rangasayee 曾在芯片製造商賽靈思(Xilinx)工作近二十年。此前,在接受媒體採訪時,他表示,許多行業由於種種原因無法使用基於雲的 AI 服務,Sima.ai 將專注於服務那些去中心化的邊緣計算設備。

例如,自動駕駛汽車需要即時做出決策,只有內置的 AI 才能滿足其對延遲的苛刻要求。而在醫療保健等行業,公司可能不希望將敏感數據發送到雲端,而希望將其保存在設備中。

2023 年 6 月,Sima.ai 表示已開始量產其第一代邊緣人工智能芯片。公司表示,正在與製造業、汽車和航空等領域的 50 多家客户合作。

Tenstorrent

成立時間:2016

應用領域:訓練&推理

Tenstorrent 由三位前 AMD 員工創辦,總部位於加拿大多倫多。

Tenstorrent 以異構和 Chiplet 設計的形式來開發 RISC-V 和 AI 芯片。目前已經開發出基於 12nm 工藝的 Grayskull 和 Wormhole 兩款芯片,FP8 算力高達 328TFlops。公司的目標是把價格壓到類似性能 GPU 的 1/5 到 1/10。

2021 年,Tenstorrent 還推出了 DevCloud,可以讓 AI 開發人員無需購買硬件即可運行大模型。

不過,最近幾年,也許是感受到了英偉達等硬件廠商的壓力,Tenstorrent 將重心轉移到了技術許可和服務領域。

Tiny Corp

成立時間:2022

應用領域:訓練&推理

Tiny Corp 由自動駕駛初創公司 Comma AI 的創始人和前首席執行官 George Hotz 創辦,其產品將以名為 tinygrad 的開源深度學習工具打造,據悉可幫助開發人員加快訓練和運行大語言模型。

Hotz 認為,tinygrad 可以成為 Pytorch(源自 Meta 的深度學習產品)的 “有力競爭者”。但目前他還沒有透露關於產品的具體細節。

風險提示及免責條款

市場有風險,投資需謹慎。本文不構成個人投資建議,也未考慮到個別用户特殊的投資目標、財務狀況或需要。用户應考慮本文中的任何意見、觀點或結論是否符合其特定狀況。據此投資,責任自負。