英偉達 IR call,信息量很大...

英偉達 IR 電話會議透露了很多信息。最大的兩個推理用例是推薦系統和生成式 AI,其中推薦系統佔 40% 中的 20%。今年的推理收入確認來自去年的購買。GTC 有超過 80% 的概率會發行 B100。供應仍然緊張,但 NVDA 能夠直接瞭解最終客户並做出相應安排。關於 CY25 年的可見性,已經有很多信號。總體而言,這些信息展示了英偉達在推理和供應方面的優勢和前景。

英偉達 IR call,信息量很大

-

產品可同時用於訓練和推理,但 NV 的客户經理和解決方案架構師可通過客户提的問題判斷用途,對每個客户 account 都有很強的可見性。

-

最大的兩個推理用例1)推薦系統,佔 40% 中的 20%(去年出卡 150w,這個比例剛好是 META 的 30w 張) -電商和社交媒體的推薦系統。(META 是一個很大的例子)…2)生成式 AI - 早期已經進入生產的客户包括MSFT Copilot、ChatGPT、NOW、ADBE。

-

去年這個比例要低得多。當客户為推理購買時,通常有幾個季度的滯後時間直到建立推理。因此,今年的推理收入確認來自去年的購買。

-

關於推理卡的競爭…幾年前,大多數推理都是在 CPU 上完成的,人們認為推理更容易。但是,對響應時間的需求、圖像生成和視頻生成提高了推理計算需求的標準。模型不斷創新、軟件不斷改進,這對 NVDA 有利。甚至在芯片升級之前,Tensor LT LLM 僅通過軟件就為 LLM 提供了 2 倍的速度提升。這就是與 ASIC 相比的好處,延長了 H100 的使用壽命。

-

供應緊張的關注…與其他終端市場相比,NV 能直接看到最終客户,從設計最終客户的基礎設施到服務器/網絡的大小,然後客户決定通過誰走交付(ODM,分銷商等)。仍處於 “allocation mode”,比如優先從機架/網絡的角度準備好了的客户。即便 cowos 供應終於趕上了,但仍在分配模式中。

-

對 CY25 年的可見性…通常沒有這麼遠的可見性。客户通常不會提前 4-6 個季度預訂。然而,已經有很多信號。瞭解垂直行業,他們自己的投資回報 ROI。(回答了之前文章的問題,ROI 決定了 GPU 投資的持續性)還將在新架構上繼續 ramp,更好的性能、降低客户的 TCO,從而推動需求。在新架構開始時,供需往往不匹配。(我們之前説的,短期看都是供需噪音,長期看是持續緊張,因為迭代太快)

-

競爭格局…客户會從軟件角度考慮他們的工作負載是否得到支持,或者是否存在軟件優化的隱藏成本(暗示 AMD?)。替代方案在性能上也有差距。通過 MLPerf 基準,你可以看到性能輕鬆拉開 2 倍差距。對客户來説不值得,因為他們還要承擔數據中心的固定成本(我理解是 TCO 比如能耗、維護),而節省的費用實際上並不能彌補這一點。性能=總擁有成本,才是客户真正在想的,而不是一個個芯片。

-

關鍵的供應限制…有 3 個限制因素,內存、Cowos 封裝、網絡。對於 H100,大部分已經緩解,現在接近結束分配(所以 lead time 3 個月很正常)。H200 下個季度將採用新的 HBM,可能又會看到限制(因為 3E 通過認證的現在就兩家,海力士鎂光)。新架構將更少地針對具體組件,ramp 時更多是小批量。(我理解是 unit 下降但 perf 上升,GPU density 繼續提升,除個別如 substrate HBM 線性上升,其他部件不見得能跟上價值量增速)。

-

從客户方面來看,數據中心功率密度是重點。大多數超大雲廠提前 2-3 年就確定了數據中心容量,計劃得很早。大多數公司延長了舊服務器的使用壽命,並將支出重新分配到加速計算上。

-

主權需求…作為數據中心的一部分相對較小,但卻是價值數十億美元的機會。主權 AI 僅被定義為該國境內的人工智能基礎設施。可能是私人和國有資金的混合,通常由當地的電信公司資助。比如日本的軟銀,新加坡的星電信。

-

企業需求拆分…略超過一半的是大型雲服務提供商,接下來最大的是消費者互聯網(電商和社交媒體)。其餘是企業,包括 GPU 特定提供商(oracle,coreweave?據説 coreweave 24 年就訂了近 1w 台)

-

B100 過渡期…現在與客户的對話是在決定在 H100、H200 和 B100 之間的支出分配。這是一個迭代過程,因為它取決於供應情況。這不是一個升級,因為 B100 不是為了替換 H100。H100 仍然會銷售。當年過渡期的 Ampere 和 Hopper 在 6 個季度內也一起銷售。對 H100 的需求將會持續。(劃重點)

-

軟件的好處…計算平台 75% 以上的毛利率包括大量軟件(加速庫、預訓練模型、CUDA)在內。第四季度實現了 10 億美元的年化收入,包括面向企業、GForce、DGX Cloud、vGPU、支持 DGX 系統的軟件。

-

本地部署的企業內部 AI…鑑於基礎設施的複雜性,大多數企業正在與雲服務提供商接觸以獲取生成式 AI 服務。這是中期內增長最快的途徑。從長遠來看,大型企業將開始計劃內部部署,處於成本考量。然而,雲需求仍將增長,畢竟每美元的 GPU 支出中,雲服務提供商收取 4-5 美元的 GPU 費用。

-

中國的影響…需求有一定的波動,供應在分配過程中進行了調整。中國客户對新產品的初步評估階段(H20),這些產品不需要許可證,但仍支持整個軟件堆棧。對客户來説仍然有價值,因為它們運行在英偉達軟件堆棧上。

-

關於 GTC 的預期…將宣佈新架構,業務各個部分都有更多新聞。

此外 from sicong:

-

GTC 80% 以上概率發 B100

-

目前有兩個版本的 B100ASP, 一個比較符合大眾預期 3.8w(工業富聯專家口徑),一個是小眾點的 3-3.3w(MS Joe Moore 提到了,如果價格激進,對 AMD 是巨大壓力)

-

目前 B100 出貨時間也有兩個版本,一個是 3Q,一個是 4Q,兩種情形下出貨量大概差 30w 張。個人偏向 4Q,因為 KYEC 的設備沒那麼快 ready

微軟對 OpenAI 的會計處理,某投行專門請了會計師來分析

根據微軟-OpenAI 研發協議,OpenAI 託管在 Azure 的推理產生的收入被確認為 Azure 收入(也就是季報中的那個 6%),但 OpenAI 使用 Azure 進行其模型訓練的工作負載,並不被確認為收入(同樣,也不在微軟的 COGS 或資本支出中)。一位專業會計師來解釋這種處理方式,並得出結論,微軟可能在按照淨額報告這些訓練收入,而不是按 Gross 總額。美國財務會計準則委員會(FASB)的會計準則 808(特別是第 45 節)規定了 “合作安排”(通常稱為合資企業)的會計處理方式。在公司 A(微軟)投資於公司 B(OpenAI),然後公司 B 反過來使用這些資金從公司 A 獲取服務(Azure 計算)的情況下,公司 A(微軟)應將這種 “交換” 的收入淨額化。

説到底微軟採取了非常保守謹慎的處理方式,假設放在 A 股,別管這種 “內循環” 是否產生利潤,還不得放到 P&L 裏面虛增一把收入...

谷歌 Demis 認可了 LLMs + Tree Search 有可能實現 AGI

“樹搜索 +LLM 是一個非常有前途的方向。我們正在研究像 AlphaGo 這樣的規劃機制,也許還可以串聯不同的想法或推理線索,並利用搜索來探索巨大的可能性空間。我認為當前的大型模型缺少這種能力(planning)。那麼,AGI 是否可能完全來自純 RL 方法呢?理論上,我認為沒有理由不能這樣做,確實有一些人在 DeepMind、谷歌和 RL 社區中正在這方面工作。然而,儘管如此,我認為最快、最可能的方式是利用現有世界中的所有知識,比如網絡上的知識,以及我們收集的知識,加上我們擁有像 Transformer 這樣可以 scaling 的算法,能夠吸收所有這些信息。因此我猜測最終的 AGI 系統將包含多模態大模型作為整體解決方案的一部分,但可能還不夠,還需要額外的規劃和搜索。”

The Information 報道了 Meta 的Llama 3,認為大概 7 月發佈,希望是能達到 GPT-4 水平,最大版本 1400 億參數。但據説負責 Llama2 和 3 安全的研究員 Louis Martin 本月離開了該公司,負責強化學習 Kevin Stone 也於本月離職。

阿里 NDR 路演要點

管理層明確表示,“今年將是投資的一年”,關注三個重點:1) 重振電商的增長;2) 處置非核心資產;3) 資本回報 4.5%(3% 股份減少 +1.5% 分紅)。公司將優先考慮 GMV 而非 CMR(客户管理收入);費率不會是優先考慮的因素(尤其是考慮到淘寶相比天貓佔比提高),並且會有一定的波動。公司承認拼多多的費率確實高於淘寶和天貓;他們估計拼多多的費率在 10% 以上,而淘寶/天貓的綜合費率在中個位數。關於餓了麼,雖然外賣被視為非核心資產,但管理層重申他們沒有出售公司的計劃,管理層稱按需配送基礎設施對淘寶 - 天貓業務具有戰略意義,並將專注於提高效率和擴大規模。此外,菜鳥在市場條件合適的情況下不會排除上市的可能性。350 億的回購不只是一個上限,公司希望確保買滿 350 億。

張俊林大佬:關於 Sora 是否是物理世界引擎

diffusion model 除了圖片裏物體間的空間關係,還可以額外學習到時間維度物體的運動規律,也就是物體的運動軌跡(蘋果會從樹上垂直落到地面),本質上是對物理世界 4 維時空的 3 維壓縮(平面二維圖像 + 時間維度),但是要注意的是:生成模型通過視頻學會的是物體的運動規律和運動軌跡,但不是物理定律,它知道蘋果應該朝下向着地面運動,因為它看過很多視頻都是這樣的,但這並不意味着它學會了牛頓的 “萬有引力” 定律。沒有人能只通過看到蘋果下落就寫出萬有引力定律公式,包括牛頓也不行,牛頓能寫出來也是經過大量實驗以及抽象的推理思考才總結出來的。可以看出,圖片/視頻生成模型強在物體外在形象的表徵、物體空間關係以及運動軌跡建模,但弱於抽象思考,即着於 “色相” 而弱於 “法”。

而語言模型 LLM,是從大量人類語言中學習知識,語言本身就是一種抽象的產物,所以 LLM 擅長對抽象知識的建模和生成,本質上 LLM 在 Transformer 的參數空間內構建了一個由抽象概念編織成的 “知識之網”,LLM 是靠不同知識之間的相互關係而不是它的 “色相” 來定義具體知識的。但其對空間概念理解比較薄弱,比如它能生成 “蘋果在桌子上面”,但是估計不太理解 “蘋果在桌子左邊” 的空間佈局是什麼意思,這源於人類對空間關係的理解主要來自於視覺信道。另外,LLM 知道某個概念但是並不知道這個概念對應的外在形象具體是什麼樣子。所以可以看出,LLM 擅長抽象知識和抽象思考,弱於對於空間關係的理解,以及物體外在具體形象的理解。所謂 LLM 長於 “法” 而弱於 “相”。

但如果二者結合,圖片/視頻模型類似人類的右腦,擅長形象思維,負責形象世界的生成;LLM 類似人類的左腦,擅長語言及抽象思考,負責抽象知識和物理法則的生成和語言描述,包括複雜物理世界規律的建模和表述。如果二者能配合好,在兩者之間建立起良好的 grounding,是有可能實現模型對物理世界的充分近似和理解。

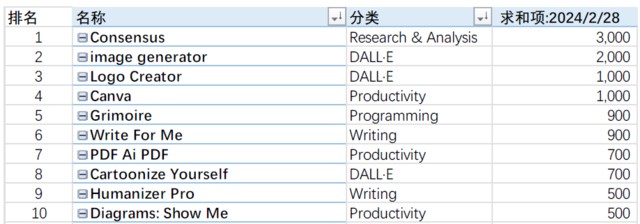

被使用最多的 GPTs 是什麼?

Will 對 GPTs 做了非常詳細的排名,你猜被使用最多的 GPTs 是什麼,果然二級狗最勤奮...

本文作者:Jason,來源:信息平權,原文標題:《英偉達 IR Call、量化 DMA、微軟 OpenAI 收入處理》,本文有刪減

風險提示及免責條款

市場有風險,投資需謹慎。本文不構成個人投資建議,也未考慮到個別用户特殊的投資目標、財務狀況或需要。用户應考慮本文中的任何意見、觀點或結論是否符合其特定狀況。據此投資,責任自負。