How strong is China's computing power?

2025 年 12 月,國產 AI 芯片企業摩爾線程和沐曦將上市,儘管目前市場份額微小,但市值已上漲超過 400%。資本市場對中國算力的預期和信心增強。與此同時,美國政府可能重新允許英偉達 H200 對華銷售,反映出對國產 AI 芯片的重視。算力被視為國家實力的象徵,未來中國算力產業的強壯與否將影響市場創新。全球算力產業鏈中,中國和美國佔據主導地位,英偉達在 AI 芯片市場佔有 60% 以上份額。

2025 年 12 月,国产 AI 芯片企业摩尔线程、沐曦相继上市。2025 年前三季度,摩尔线程营收 7.9 亿元,沐曦 12.4 亿元,两家公司在国产 AI 芯片市场份额均在 1% 左右,营收规模、市场份额在现阶段中国算力市场微乎其微,但两家公司不到一个月,市值均上涨超过 400%(截至 12 月 26 日)。资本市场对它们的热捧,主要基于中国做强算力的预期和信心。

几乎同期,美国政府释放出将重新允许英伟达 H200 对华销售的信号。一个背景是,美国政府长期面临英伟达等美国芯片企业的商业和游说压力,国产 AI 芯片近两年正朝 “能用” 到 “好用” 前进。美国政府需要重新评估对华芯片出口管制的力度。

芯片是整个算力系统的 “心脏”。在当前国际环境下,它是否强壮自主,意味着中国算力产业未来是否能够强壮有力。国产算力被寄予长期安全与自主可控的期待。在现实业务中,企业仍需在效率与成本之间反复权衡,英伟达客观上仍是性价比最高的选择。

“算力即国力”,这句话已被讨论三年。算力是什么?它是 AI 时代的电力。但与电力这种资源不同,算力决定了市场创新的上限。这三年,它的边界随着 AI 技术的发展不断被拓宽——它既包括芯片等硬件,也包括算法模型、云和软件,还受到能源、网络影响,最终要通过应用被真正使用。

目前,全球算力产业链(包括芯片相关设备、算法模型、云和软件等)最完整的两个国家,分别是中国和美国。近三年全球人工智能产业的创新几乎都在这两个大国诞生。

最核心的 AI 芯片领域,英伟达占据了全球至少 60% 以上的市场份额。美国算力基础设施建设也一路狂奔。近三年,美国五家科技公司资本支出约为中国七家科技公司和电信运营商的 3.5 倍,天然可以采购更多数量、性能更强的芯片。

《财经》统计发现,微软、亚马逊、谷歌、甲骨文、Meta 2023 年-2025 年资本支出总额约 8400 亿美元(约合 5.9 万亿元),同期中国科技公司和电信运营商(包括阿里、字节跳动、腾讯、百度、中国移动、中国电信、中国联通)资本支出总额约 1.7 万亿元。

三年前,中美算力产业规模还可以用服务器规模简单对比,但随着这三年算力产业的边界拓宽,它已经变成两个创新系统的对比。

这也引出了一个问题——在算力投资规模明显处于劣势、先进 AI 芯片供应受限的情况下,中国算力的竞争力究竟来自哪里?答案是,把芯片、算法、能源等要素组合成一个效率更高、成本更低的系统,把算力应用在更多真实需求中,并形成可持续的商业回报。

近三年来,中国产业界在采取一切能使用的策略,从芯片、算法、能源、应用等各个方向寻找突破口。

国产 AI 芯片已实现规模化量产。华为昇腾、百度昆仑芯等产品,正被用于真实业务,它们走过了不可用的门槛。中国科技公司正通过算法创新与工程优化,“榨干” 每一枚芯片的 Token(词元)。一些企业还在利用西部适宜地区的低价绿电,降低单位算力成本。

市场是无形的手,政策是有形的手。中国算力产业发展过程中,产业政策一直发挥着重要作用。

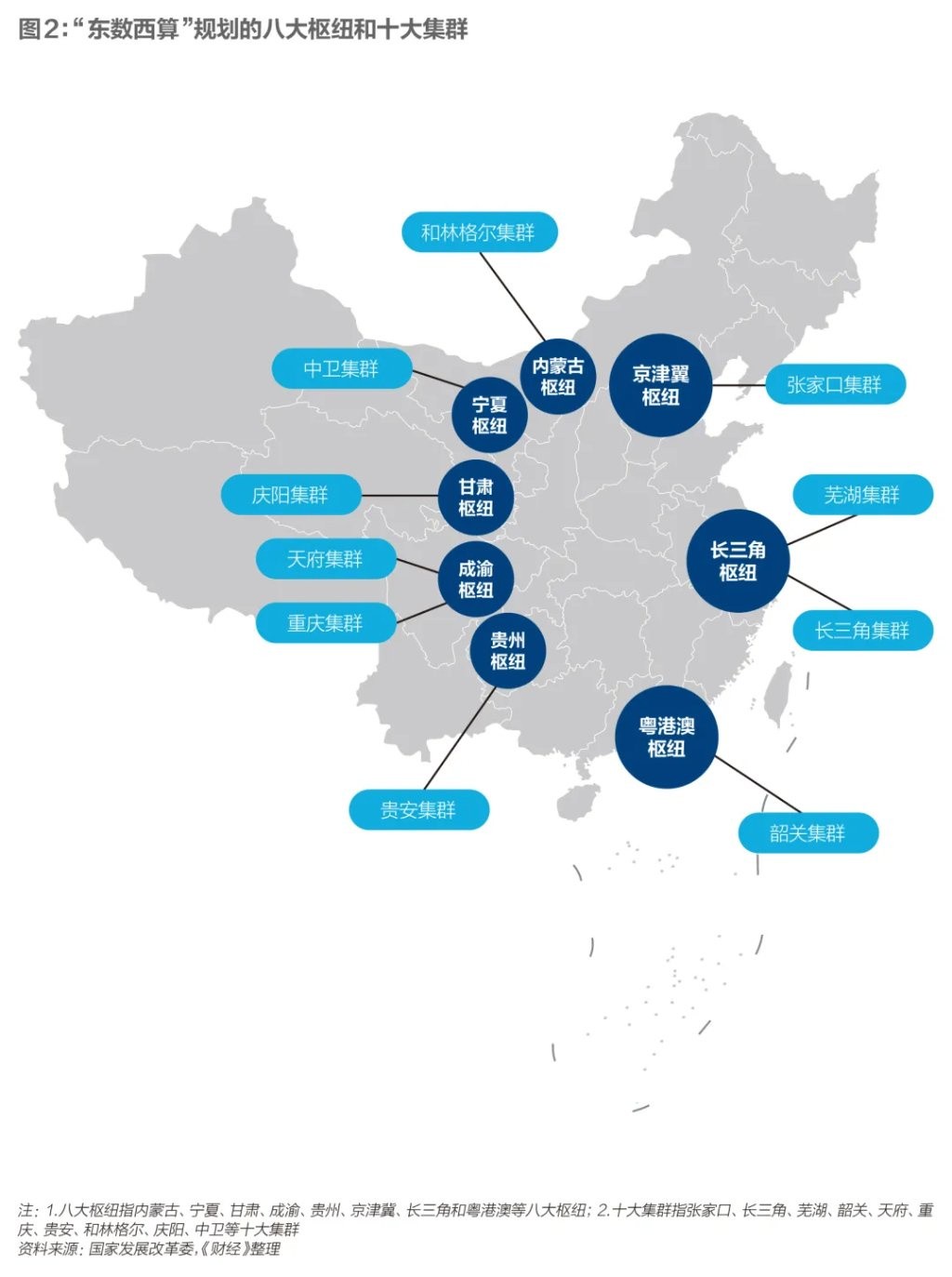

2022 年 2 月,国家发展改革委等四部委联合印发文件,同意启动建设八大国家算力枢纽节点,并规划了十个国家数据中心集群,“东数西算” 工程启动。2023 年 12 月,国家发展改革委等五部委发布《关于深入实施 “东数西算” 工程,加快构建全国一体化算力网的实施意见》,全国一体化算力网政策出炉。

在这些政策的引导下,中国算力区位布局正变得更合理。过去几年数据中心分散建设的情况已有好转。算力背后的能源成本、网络成本也在持续下降。

国产 AI 芯片,如何突围

国产 AI 芯片的真正命题不是替代英伟达,而是被投入真实业务场景,加快从 “能用” 到 “好用” 脚步

芯片一直是中国算力产业不确定性最大的一环。

国产 AI 芯片的核心问题,不是能否全面替代英伟达,而是能否进入真实业务的 “使用 - 反馈 - 迭代” 正循环。目前,国产 AI 芯片不仅性能(包括峰值性能、带宽内存等)和英伟达的旗舰芯片存在差距,市场份额也远低于英伟达,不能完全满足市场需求。

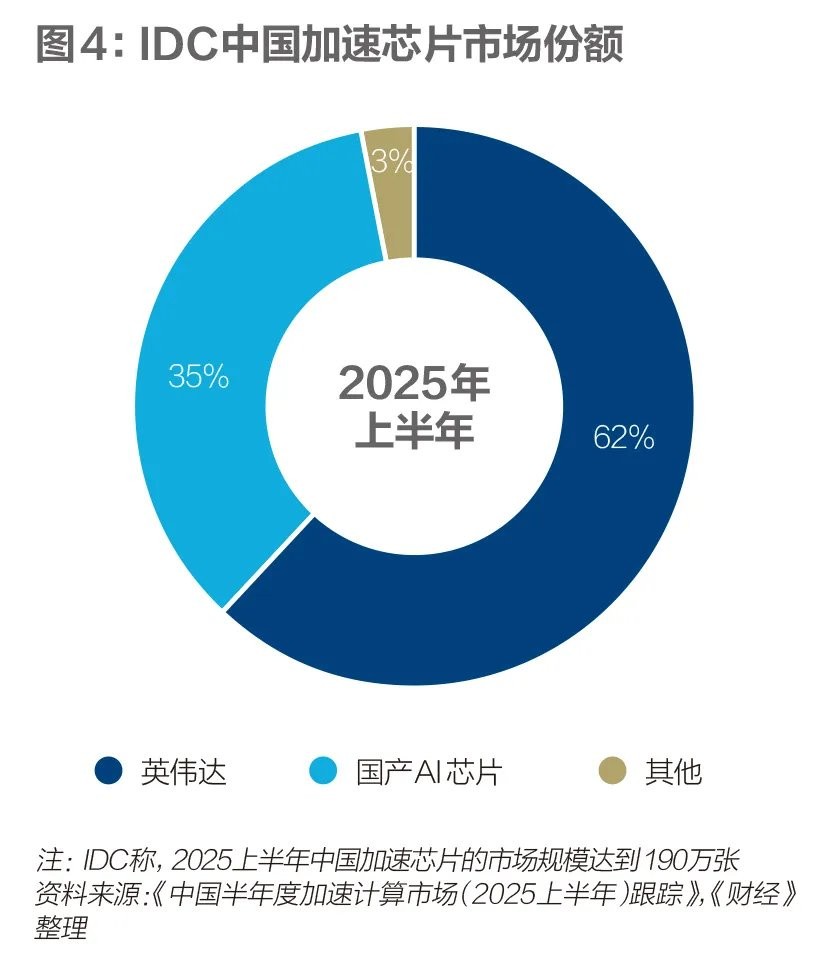

国际市场调研机构 IDC 2025 年 10 月数据显示,2025 年上半年中国加速(即 AI 芯片)服务器市场规模达到 160 亿美元,同比 2024 年上半年增长超过 1 倍。2025 上半年中国加速芯片市场规模超过 190 万张。英伟达约占 62% 市场份额,本土芯片约占 35% 市场份额。非 GPU(图形处理器,即英伟达的产品)芯片需求持续增长,增长速度远超 GPU。

严格的出口管制客观上加速了国产 AI 芯片的自主化进程。国产 AI 芯片包括华为昇腾、百度昆仑芯、阿里 PPU、寒武纪等十余个品牌。如果只算经济账、效率账,英伟达仍是最优解。但经过多次出口管制,企业都在寻找自主可控的方案。

英伟达之外,华为昇腾 910 系列是目前使用最多的国产 AI 芯片,包括三大电信运营商、字节跳动、阿里、腾讯、百度、蚂蚁集团等企业都在使用。据《财经》不完全统计,包括中国移动、中国电信、蚂蚁集团都部署了使用国产 AI 芯片的万卡集群。

目前,国产 AI 芯片走过了 “不可用” 到 “可用” 的门槛。它已被用于模型训练。

2025 年上半年,华为用昇腾 910 系列训练出了 1350 亿参数的盘古 Ultra 和 7180 亿参数的盘古 Ultra MoE。2025 年 5 月,一位华为资深技术人士在一场小规模沟通中对《财经》介绍,华为用系统工程手段解决了昇腾 910 系列单卡性能相对不足的短板。华为投入了超过 1 万人的研发团队,华为云、计算产品线、海思、2012 实验室、数通产品线、光产品线等团队都参与其中。华为 2025 年 9 月还公布了昇腾未来三年四款芯片的路线图。

百度 2025 年 2 月也点亮了昆仑芯 P800 万卡集群,并计划未来点亮三万卡集群。在芯片或系统领域,“点亮” 是指首次通电并成功运行基础功能或软件系统的过程。这意味着硬件设计基本成功,可以进入下一阶段的测试和优化。

一位了解该产品的资深技术人士对《财经》表示,经过近两年持续迭代,在典型训练场景下,昆仑芯 P800 模型训练精度对齐问题已不是主要障碍。在训练中小参数模型时也有一定性价比。后续重点是性能和工程层面的持续优化。

不过,国产 AI 芯片用于大模型训练时,成本仍然偏高,且需要更长的周期。

一家计算机视觉企业的模型训练负责人 2025 年 11 月曾对《财经》表示,他们 2025 年用英伟达某款芯片训练了一款小参数视觉理解模型,后来尝试用昆仑芯 P800 复现,发现同样能达成目标。只是训练周期要长 20% 以上,综合成本会高更多。

在门槛更低、使用更多的推理场景,部分国产 AI 芯片性能表现,已超过英伟达 H20。英伟达 H20 是一款为了符合美国出口管制政策,性能被大幅阉割的 “中国特供版” AI 芯片。

一位地方国企智算技术人士 2025 年 12 月对《财经》表示,他测试了华为昇腾 910B、百度昆仑芯 P800、阿里 PPU 等国产 AI 芯片的推理性能。百度昆仑芯 P800、阿里 PPU 跑 DeepSeek-R1 和阿里千问等经过适配优化的模型,Token 吞吐效率优于英伟达 H20。不过,国产 AI 芯片适配新模型,通常要一两个月。

AI 基础设施创业公司新智惠想创始人吴健对《财经》表示,他和十家以上的国产 AI 芯片企业都有接触。他发现,国产 AI 芯片在快速进步。2026 年-2027 年中国市场还会多款国产 AI 推理芯片上市,预计该市场 2026 年-2027 年会迎来爆发。

国产 AI 芯片正在艰难地建立软件生态。软件生态是为特定硬件(如 AI 芯片)建立的一套完整的软件工具、编程模型、优化库和开发者社区的总和。它的核心是让开发者能够方便、高效、稳定地利用这块芯片的算力,避免长期处于低效开发和难以规模化的状态。

大量工程师正在实际业务的锤炼中,为芯片写算子(深度学习最小的可执行计算单元)、修 Bug(程序错误)。工程师要把基于英伟达 CUDA 软件生态的代码,重新写在国产芯片的软件栈上,再把计算精度和英伟达的芯片对齐。算子适配和精度对齐,决定了究竟要花多少芯片、多长时间才能达到英伟达相同的效果。

2023 年之后,各类模型逐渐收敛到 Transformer(大语言模型)、Diffusion(文生图)这两大架构。这为国产芯片缩小与英伟达 CUDA 生态差距提供了窗口期。一位资深算法工程师对《财经》解释,2023 年之前芯片厂商要适配的算子数量超过 2000 个。但现在,以目前阿里千问系列、DeepSeek 系列等主流模型为例,要适配的核心算子大约只有几百个。

2025 年,美国政府两度松口,试图放松对中国的芯片出口管制。2025 年 7 月一度称可向中国出口 H20,12 月称可向中国出口 H200。

英伟达作为商业企业,它迫切期望服务中国市场。英伟达创始人黄仁勋 2025 年 7 月在访华期间曾对《财经》等媒体表示,中国是全球第二大技术市场,并且发展迅速。这是一个非常重要的市场,充满活力。我们在中国有非常优秀的客户,我们希望能够服务他们,并将继续这样做。

一种观点认为,美国政府阶段性放松出口管制背后一种考量是——让英伟达抢占中国市场的同时,也让中国企业离不开英伟达的软件生态。

中国企业此时面临两难——不用英伟达,基础模型训练难度更大、成本更高,未来会在大模型性能竞赛中落后。但过于依赖英伟达可能会削弱国产芯片现有的软件生态。国产 AI 芯片刚建立的 “用户 - 反馈 - 迭代” 生态可能会被影响。

如何面对这个两难选择?

另一位算法工程师的看法是,英伟达的旗舰芯片事实上仍是国内基础模型训练的主流选择。英伟达 H200 等芯片该买还是要买,它在万亿参数的基础模型训练中不可替代。

但他认为,国产芯片不能只停留在推理阶段,还要真正投入精力用于中小模型、行业模型、垂直模型以及模型精调场景,甚至是基础模型训练的验证。只有持续暴露问题、修复问题,才能逐步养生态,把国产芯片的软件栈打磨到稳定可用。

事实上,国产 AI 芯片真正的对手不是英伟达,而是被真正使用。被采购只是第一步,它们更需要更多真实业务场景锤炼,以及抓住接下来三年至五年 “从能用到好用” 的时间窗口。

算法和工程,另一个突破口

做好硬件适配、调度优化等工作,有可能将同样的芯片、同样的模型发挥出数倍以上的 Token 吞吐性能

在芯片长期受限的情况下,要发挥现有芯片的性能,需要更多依靠算法创新、工程优化。

当算力规模无法正面比拼时,决定差距的不是有多少芯片,而是每张芯片能吐出多少 Token。Token 是模型推理的基本单位。当算力规模受限时,每秒能生成多少 Token(Token/s),直接决定了 AI 服务的响应速度、吞吐量和成本。这是衡量芯片实际推理效率的核心指标。

算法创新和工程优化,一直是中国算力产业可以挖掘潜力的领域。当单位 Token 成本更低的时,芯片使用成本也会被摊薄。

由于美国政府长期对中国实行芯片出口管制,多位行业人士对《财经》表示,在采购同等算力规模的硬件时(如采购英伟达或自研芯片),中国企业的综合采购成本,往往较海外市场高出约 20%。这体现在多个环节,如供应链路径拉长导致的渠道溢价,部分国产算力硬件在代工等环节综合成本上升。

中国科技公司手中既有英伟达的芯片,也有其他国产芯片。不同品牌的芯片甚至被混合部署在一起。如何充分用好手头的每一张芯片,都变得极为重要。

这倒逼中国科技公司在算法创新、工程优化等层面提升算力效率,“榨干” 每一张芯片的 Token。

DeepSeek-R1 2025 年初引发轰动的原因之一就是算法创新——采用 MoE(混合专家)架构和 MLA(多潜头注意力)机制。每次调用 6710 亿参数的基础模型,只激活 370 亿参数的专家模型,并把专家模型部署在不同芯片并行计算。这种策略减轻了单卡负荷,也提升了芯片利用率。DeepSeek R1 单位 Token 定价,仅有当时对标的 OpenAI o1 的 5% 左右。

包括阿里、字节跳动、百度等中国科技公司,也在软件工程层面采用各种手段提高算力利用效率。

常用的三项技术包括——潮汐调度(削峰填谷,错峰利用芯片资源)、P/D 分离(将推理中的计算密集型任务、高带宽任务分配到适合的芯片上)、KVCache(通过缓存上下文,减少重复计算)。这些做法最终目的,都是让芯片便宜地 “吐出” 更多 Token。

字节跳动旗下火山引擎智能算法负责人吴迪 2025 年 12 月对《财经》表示,利用上述技术,火山引擎在云上可将推理成本降至自建机房的 10%-20%。

吴健直言,芯片是资产,但算力才是生产力。买不到芯片可能会滞后。买到却浪费,会一直落后。他分析,过去大家对芯片、模型关注度更多,对系统工程关注少。但这里挖掘潜力很大,做好硬件适配、调度优化等工作,有可能将同样的芯片、同样的模型发挥出数倍甚至数十倍的 Token 吞吐性能。

无论是算法创新,还是工程优化,本质上都是系统能力,这对芯片、网络等资源的使用提出了更高要求。从工程实践看,这些能力往往难以在单一企业、自建机房的条件下长期维持,更适合在具备万卡甚至 10 万卡算力规模,且拥有成熟调度体系的公共云之上。

中国信息通信研究院截至 2024 年 5 月数据显示,当时全国建设和规划中的智算中心共有 185 座,总算力约 272 EFLOPS(每秒百亿亿次浮点运算次数),已建成并投入运营的算力约 104 EFLOPS。云服务形式对外提供算力的比例为 23%。这意味着,一部分芯片仍以封闭分散的方式运行,潜力尚未被充分挖掘。

在今天 AI 技术竞赛的过程中,云的作用甚至不亚于芯片。

AI 几乎天然长在云上。基础模型的训练、推理,持续迭代和规模化应用,几乎在云上完成。在公共云上,算力、模型、应用才能快速部署、弹性调度,并触达更多用户。

事实上,包括微软、亚马逊、谷歌等科技公司之所以能长期在 AI 竞赛中保持领先,一个重要原因是,它们通过公共云的形式,向全球市场提供算力、模型、应用服务。全球最大 AI 创业公司 OpenAI 的 GPT 系列模型诞生在微软 Azure 上,全球第二大 AI 创业公司 Anthropic 的 Claude 系列模型是在亚马逊 AWS 和谷歌云 GCP 上训练出的。

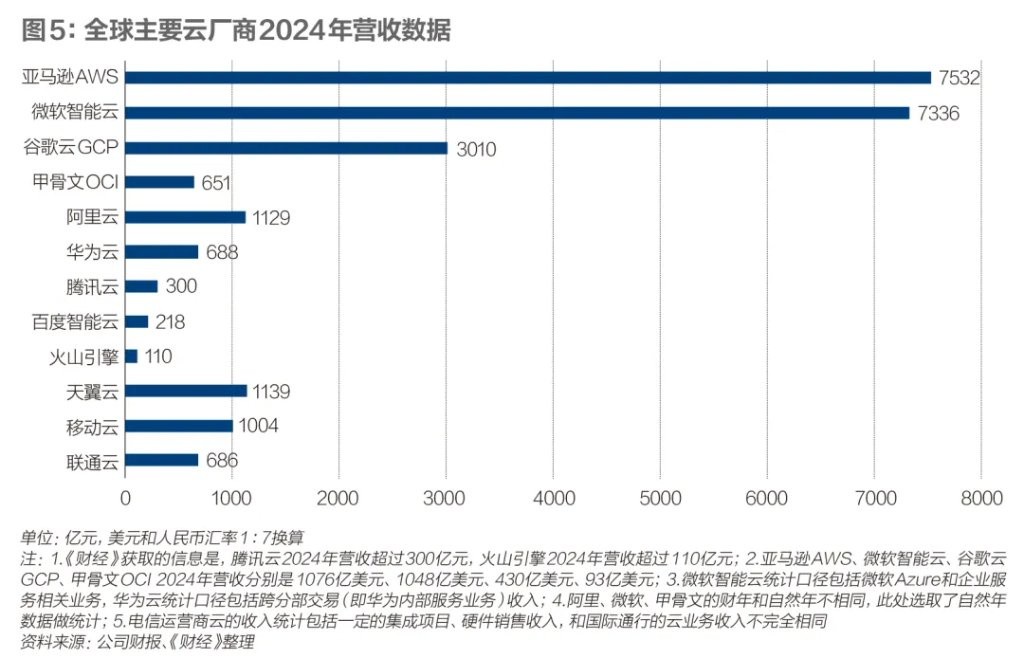

公共云不仅加快了模型、应用迭代速度,还带来了商业循环。亚马逊 AWS、微软 Azure、谷歌云 GCP、甲骨文 OCI 这四家云厂商 2024 年总营收 2647 亿美元(约合 1.85 万亿元)。中国市场,有五家科技云厂商(阿里云、华为云、腾讯云、百度智能云、火山引擎),三家电信运营商云(天翼云、移动云、联通云)。八家云厂商 2024 年总营收约 5270 亿元。美国云厂商总营收约为中国云厂商的 3.5 倍。

中国云计算市场竞争激烈。阿里云智能集团资深副总裁、公共云事业部总裁刘伟光 2025 年 5 月在一场主题为出海的专访中对《财经》表示,美国主要有四家云厂商,它们面向全球。中国大小十余家云厂商,主要服务国内且高度内卷,大盘增速不到 15%(国际市场调研机构 IDC 2024 下半年数据)。中国云厂商必须在国际市场具备竞争力,否则只能坐以待毙。

事实上,中国云市场还未得到充分挖掘。公共部门、政企机构甚至很多制造企业都对公共云尤为谨慎。

这是一系列复杂因素造成的。云计算 2014 年之后在国内逐步被推广,至今仅有 12 年。它虽已被互联网、汽车等行业被广泛使用,但在政企行业、公共部门还没有被完全理解和接受。

和芯片、服务器等硬件相比,云看不见、摸不着,且采用年/月订阅或按量付费的灵活模式。这种付费模式并不直观。目前,公共云在公共采购科目中尚无明确归属,主要列入维护费用类项目。它受按采购固定资产 15% 配置的限制。

在大部分政企机构、公共部门现有预算采购、审计机制下,云是费用支出,服务器等硬件是固定资产。云按年订阅付费,容易影响当期利润指标。服务器哪怕摊销成本更高,报表上体现是存量资产。因此大部分政企机构、公共部门宁愿购买服务器等硬件。

2024 年 12 月初,在《财经》参加的一场政策研究部门组织的小规模讨论中,一位政策研究部门人士提出,全球 AI 技术竞争加剧,且国内部分智算中心资源闲置的背景下,公共云或许可以成为一种选择方案。在他看来,公共云在资源调度、弹性扩展等方面有优势,有助于提高算力效率。

他建议,未来可以适时调整固定资产的范畴,拓展至公共云产品的支持。还可以优化政企机构的 IT 产品和服务采购办法,鼓励政企机构和公共部门数字化转型优先上云。但这些设想仍需在财政、审计等多个层面进一步论证。

一位头部 ICT 硬件企业政策研究人士对《财经》表示,近三年他多次向相关政策部门介绍公共云的重要性。三年前,多数人对云缺乏了解,或是担忧云的安全性。近两年 AI 浪潮来临,云的效率优势逐渐得到认同。但在实际推进过程中,云的付费模式和预算管理、采购流程、审计规则之间仍无法很好对接。

能源优势如何发挥?

“算力的尽头是电力”,电力越来越成为影响算力的重要变量。电力并非算力成本中占比最高的一项,但却是决定算力能否持续扩张,以及单位算力成本能否下降的影响条件

无论是中国还是美国,建设数据中心的前提都是——在合适的位置,获得长期、稳定、可预期的电力供应。

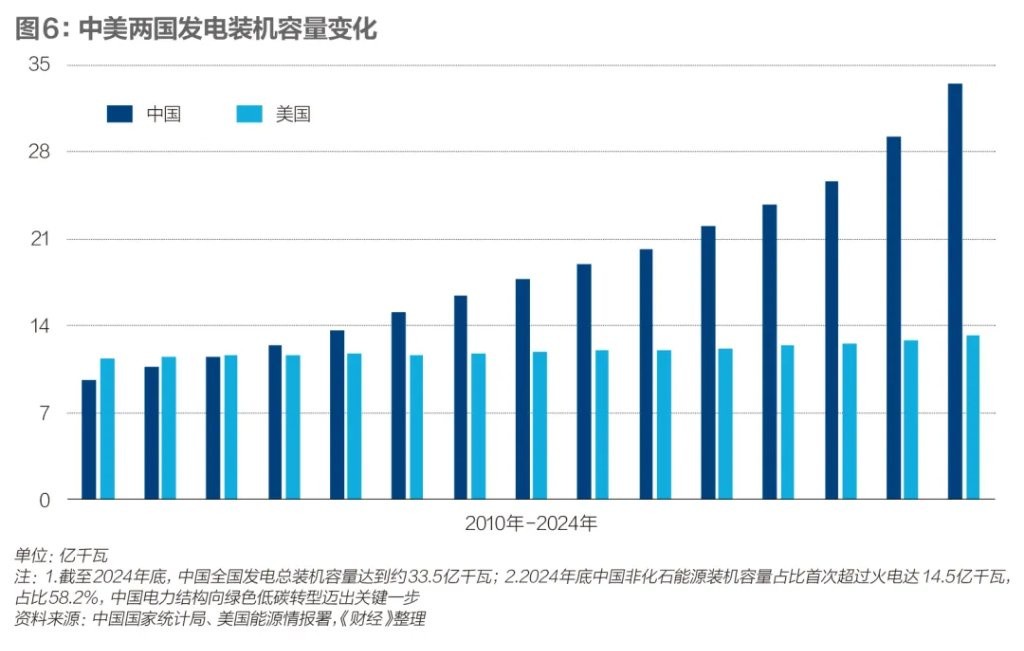

电力目前是中国算力布局中的一个现实优势条件。中国在西部地区拥有相对充足、价格较低的风电和光伏资源。而美国的数据中心建设,则暂时面临电力系统制约。

过去十年,美国社会用电总量增长缓慢。近三年,美国用电净增量主要来自数据中心建设。美国能源信息署数据显示,2024 年数据中心在美国社会用电量占 4%,2030 年会增至 9%。但美国电网平均服役年限已有 40 年,新增发电与输配电能力建设进展缓慢,难以应对算力激增的需求。

高盛 2025 年 7 月报告显示,2023 年起美国数据中心电力缺口一直在 10GW(吉瓦是功率单位。1GW 算力集群可容纳 20 万枚英伟达 GB200 芯片)左右。美国每年新增发电容量仅为 12GW。巴克莱银行 2025 年 10 月报告统计称,包括亚马逊、微软、谷歌、甲骨文、OpenAI 等科技公司和数据中心服务商的算力投资规划至少有 45GW。

缺电正在成为美国算力投资计划能否落地的关键因素。微软 CEO(首席执行官)萨蒂亚·纳德拉(Satya Nadella)2025 年 11 月在一场播客中称,如果不能快速在有电力的地方建成数据中心,可能会有大量芯片在仓库无法通电。纳德拉说,“这是我今天面临的问题。”

为解决缺电问题,部分美国科技公司开始尝试新思路。微软、谷歌、亚马逊等企业已陆续与核电站签署项目开发协议,为未来三年至五年引入小型模块化核电(SMR)预留条件。

算力成本结构中,电力并非占比最高的一项,但直接影响单位算力成本。黄仁勋近两年在多个场合提到,“我们要计算每兆瓦的每秒 Token 数。”

中国信息通信研究院云计算与大数据研究所副所长李洁对《财经》表示,数据中心总拥有成本(TCO),涵盖从规划建设、运营改造到退役的全生命周期费用。整体可划分为资本支出(CapEx)和运营支出(OpEx)。资本支出以土建工程、机电配套、IT 设备等一次性投入为主;运营支出则包括水电费、人员薪酬、设备运维费、带宽网络租赁费等。

如何发挥能源优势?李洁认为可从三方面发力。一是做好 “算电协同” 发展模式,推动适合的算力中心向能源富集、气候适宜的区域优化布局。二是鼓励创新建设运营模式,探索绿电直连、源网荷储一体化、高效储能等模式,适配超大规模算力中心的未来发展需求。三是积极引导算力用户优先选用绿色算力,推动清洁低碳效益向各行业延伸传导。

电力在以 GPU 为主的数据中心中,综合成本约占 10%。根据《财经》粗略估算,中国几家头部科技公司 2024 年综合电力成本(含数据中心和办公楼宇电力)均为数十亿元,对比当年 700 亿-800 亿元资本支出,这看起来暂时不算高,但它未来会快速增长。

中国信息通信研究院 2025 年 6 月报告显示,2024 年中国数据中心用电量 1660 亿千瓦时,占社会用电量比例 1.68%。按照中等增速,预计 2030 年底数据中心耗电量占社会用电量比例将达 3% 左右。

国产 AI 芯片工艺制程受限,单位算力能耗偏高(英伟达 H200/GB200 芯片采取 4 纳米工艺,国产 AI 芯片普遍在 7 纳米工艺以上)。一些中国企业在采用 “用瓦特换比特” 的思路——在部分西部枢纽节点城市部署数据中心,利用低价且相对充足的绿电资源,抵消国产 AI 芯片在能效上的劣势,从而降低单位算力成本。

国际半导体和 AI 市场调研机构 SemiAnalysis 2024 年数据显示,美国数据中心使用的平均工业电价 0.083 美元(约合 0.59 元)/千瓦时,各州数据中心电价各不相同。中国市场西部枢纽节点城市电价普遍更低。内蒙古乌兰察布等西部枢纽节点城市的电价甚至在 0.3 元/千瓦时以下。包括阿里、华为等科技公司都将超大型数据中心部署在乌兰察布。

多位数据中心行业者对《财经》表示,数据中心实际电力成本,通常由基准电价、输配电价、容量电价及储能摊销等成本组成。他们正在通过签署 PPA(企业直接签署的供电协议)、源网荷储、绿电直连等方式使用风电光伏等绿电,并持续降低电力成本。

秦能科技是一家算力基础设施服务商,它服务国内大型科技公司。秦能科技创始人、CEO(首席执行官)居静 2025 年 8 月接受《财经》专访时表示,公司在山西大同建设的多个数据中心,采取在园区周边 20 公里范围内投资建设 300 兆瓦以上风电、光伏和储能设施的方式,实现绿电直连。这相较传统供电模式,可下降 30% 以上的电力成本。在他看来,部署 AI 芯片的数据中心需要独立设计电气架构,形成适应高功耗特性的微电网,以降低对大电网的依赖。

不过,在现有电力体系下,数据中心难以完全脱离大电网运行。在提高绿电占比的同时,数据中心仍需向电网支付备用容量费用。因为电网的固定资产折旧、输配电成本并不会因用户自发自用而同步下降,相关成本仍需通过容量电价等方式进行分摊。

隔墙售电等交易方式在实践中也有挑战。如果企业自建光伏风电后,既发电、又输电、又供电,甚至一对多供电,这将与电力监管和交易规则存在冲突。

长期来看,算力产业若要持续发挥能源优势,仍需建立在更加灵活的能源系统之上。因为国际市场正逐步提高对绿电标准,不再只关注年度绿电比例,而是向小时级绿电演进。

GHG Protocol(温室气体核算体系,一套国际公认的温室气体核算和报告标准框架)指导委员会委员翟永平对《财经》表示,目前多数科技公司承诺的 “2030 年之前实现 100% 绿电”,主要指年度用电总量与绿电采购量的平衡,并不意味着全天候使用绿电。现实中,数据中心夜间仍需依赖煤电。他解释,若未来按照小时级绿电标准衡量,分布式能源、绿电直供的重要性将进一步凸显。如果考虑更长远,小型模块化核电也可能是探索方向。

在西部使用低价绿电,并不等于综合成本最低,还有一个限制条件是——网络成本。因为东西部跨区域传输的网络费用、时延带来的业务损耗,可能会抵消一部分电价优势。

没有直连专线的情况下,东西部之间网络传输要经过层层绕转。部分西部枢纽节点城市无法完全满足东部 20 毫秒内时延的需求。因此,企业倾向把低时延业务(实时结算、视频会议、实时推理等)部署在东部,对时延需求不高的业务(如冷数据存储等)部署在西部。

问题的关键在于,降低东西部网络的成本和时延的同时,还要保证三大电信运营商的投资回报率。《财经》了解到,一些东西部枢纽节点城市间的直连网络正在建设。一些数据传输规模大的东西部城市间,三大电信运营商也推出了 “东数西算” 优惠套餐。

中国算力的能源优势,最终不单独取决于能源总量和电力价格,而取决于能否和算力、网络在一个账本上统一设计。

算力的目的,是应用繁荣

上一轮移动互联网基础设施的强壮,造就了中国延续十多年的移动互联网创新。这一轮算力基础设施建设的目标,是带来新一轮市场创新

算力最终还是要被应用,才能发挥实际价值。被足够多的用户使用,也是摊薄每个 Token 算力成本,带来新一轮应用创新的最有效方式。

美国拥有庞大的软件生态作为支撑,这是其算力得以持续使用的关键。在公共云上,形成了 IaaS(基础设施)、MaaS(模型平台)、PaaS(平台软件)、SaaS(应用软件)的完整生态。云厂商花费资本支出购买芯片提供算力,SaaS 与 PaaS 通过服务客户持续消耗算力,模型公司训练基础模型提供 AI 能力。这形成了一个庞大的生态闭环。

美国市场 2025 年 11 月出现了 “算力泡沫” 讨论。投资者担忧,庞大的资本支出最终无法转化为实际收入。甲骨文和 OpenAI 的确存在泡沫,但亚马逊、微软、谷歌的算力供不应求积压订单。截至 2025 年 6 月末,三家公司积压订单(即剩余履约义务,财务指标是 RPO)分别是 3680 亿美元、1950 亿美元、951 亿美元,是各自 2024 年云收入的 2 倍以上。

中国 To B(面向企业级)市场形成了云、模型、软件、服务、硬件的完整拼图,但一直未能形成类似的庞大软件生态——一套相对标准化的软件市场。

由于 IT 发展进程、采购习惯不同,国内数字化市场的长期现状是,硬件大于软件。AI 和软件的能力,更多是通过系统集成、行业服务才能真正落地。这和通过软件直接带动算力消耗不同,这个路径相对漫长,且伴随着更高的人力定制和服务成本。中国 To B 软件市场从业者 2021 年-2023 年长期在思考的一个问题是——软件市场的出路到底在哪里?

2025 年,一个新的变量出现——AI 可以通过智能体(Agent)这种更碎、更轻、门槛更低的形式,嵌入到业务系统中。从目前最新的市场实践来看,它正在更多与真实业务效果直接挂钩,甚至在逐渐从订阅付费,走向按效果付费。

与国际市场通过软件持续带动算力消耗不同,中国的应用落地,一开始就更像工程问题——它无法依赖单一软件,而取决于能否被嵌入真实业务,并在长期业务中被使用。

百度智能云大模型平台总经理忻舟长期服务政企行业(金融、能源、交通、制造等大型集团企业)。他观察到的情况是,和两三年前更多强调采购硬件、建设平台不同,2025 年以后这类企业的数字化转型逐渐进入深水区,它们对 AI 投资回报率要求更高,越来越把目光更多聚焦在 “高价值场景”——包括电网调度、供应链优化、机械故障诊断、AI 科学研究等实际业务。

如何解决这些实际问题?忻舟解释,这类大型集团企业落地 AI 应用的典型模式是,采购硬件设备搭建基础设施、软件平台,训练专精模型,再通过智能体协同等方式获得可开箱即用的应用。比如,中国能源建设集团广东院的海上钻油平台管道布线等问题,就采用了百度的 “伐谋”(一款面向生产研发环节的 AI 自主优化引擎)进行算法优化,这取得了可精确计算的业务回报。

在过去,政企行业(金融、能源、交通、制造等行业)的数字化建设强调硬件资产交付,交付即结束。但今天,落地 AI 的交付逻辑不同。基础模型每三个至六个月就有一轮迭代,容易出现 “建成即落后” 的情况。上述行业对技术及时更新的诉求正在变强。

忻舟的看法是,哪怕是用私有云,也可以尽量尝试订阅制(订阅模型、软件服务等)。这样厂商可以帮客户持续迭代技术,避免因技术过时导致的资产闲置。事实上,软件订阅,甚至是效果付费呼声很高,这有赖于采取更灵活的预算机制。

国际市场调研机构 Omdia 高级首席分析师詹墨磊认为,Agent 正在拆解 SaaS 的功能,旧的软件形态正在被打散。如果从这个视角看,Agent 可能会改变 SaaS 渗透率。他同时认为,专业软件工具的复杂性决定了用户规模会相对有限。

2025 年,另一个正在逐渐萌芽的方向是,中国市场的 AI 应用未来不一定会直接长成 SaaS/PaaS 软件,而在于能否被嵌入更多硬件设备,被反复、低价、长期调用。

一位软件行业投资人 2025 年 11 月对《财经》表示,他们 2025 年之后把更多精力投入到机器人、自动驾驶、物理 AI 等赛道。他看到的真实情况是,越来越多硬件正在和 AI 结合,产生更大价值。中国有更强的生产制造能力,更低的供应链成本。如果搭载 AI 的硬件设备逐渐被用户更多使用,算力同样会被真正使用。

联合国统计司数据 2025 年显示,2024 年中国制造业增加值 2023 年总额达 4.8 万亿美元,占中国经济总产出的 27%。它在全球制造业增加值占比 28.9%,美国占比为 17.2%。中国制造业的创新能力,在未来 AI 应用中可能会带来潜在的比较优势。

越来越多硬件——如手机、AI 眼镜、自动驾驶、机器人、工业设备,甚至是毛绒玩具都在接入大模型,成为潜在的算力消耗设备。这些都是由真实需求驱动的。

一个不起眼的案例是,2025 年 AI 玩具正在中国市场悄然流行。在深圳,电子制造供应链可以快速把大模型 API(应用接口)塞进玩具。一个不足 100 元的可对话毛绒玩具,背后通过云端连接阿里千问、字节跳动豆包的模型。一个孩子每和它对话一次,千里之外的数据中心的芯片都在高速运转生产 Token,单位算力成本也将因此降低。

一位 AI 玩具从业者对《财经》表示,中国市场的软件订阅付费习惯不成熟,他们产品定价时没采用每年支付 Token 费用的方式,而是直接计算产品三年生命周期 Token 总成本,一次性计入硬件售价。他估算,目前 1 万台 AI 玩具平均 1 台每年 Token 消耗成本约为 6 元-10 元,这还是行业早期互动频率不高的计算结果。

AI 玩具的算力使用量微乎其微,但重要的是,它代表了一种方向——算力不再只是以软件订阅形式被感知,而是被埋入硬件的生命周期,随着使用频率被持续消耗。这个模式一旦在更高价值的硬件上成立,它会带来更大的潜力。

智能汽车、具身智能机器人、工业设备,都有可能是这种高价值硬件。“杭州六小龙” 之一的群核科技原本为家装行业提供设计软件。它过去十多年积累了空间数据和空间计算能力,这家公司正在为智元、银河通用等机器人公司提供空间模型能力。

群核科技董事长黄晓煌 2025 年 12 月接受《财经》专访时表示,未来五年至十年,所有智能设备都需要空间智能模块。现在的机器人只有小脑(运动控制能力),未来还要有大脑(空间识别能力)。未来不会有纯软件公司,或者纯硬件公司。

中国 AI 应用爆发的趋势正在出现。国家数据局 2025 年 8 月数据显示,2024 年初中国日均 Token 消耗量 1000 亿。截至 2025 年 6 月底,中国日均 Token 消耗量已经突破 30 万亿。一年半时间增长了 300 多倍,这反映了中国 AI 应用规模的快速增长。

算力消耗快速增长的同时,一个更 “功利” 的问题也开始浮现——中国在 AI 时代,能否像移动互联网时代一样,诞生一批创新企业?

一位长期从事信息化产业政策研究的产业资深人士对《财经》表示,回顾 2013 年-2019 年,4G 通信基础设施高速发展阶段,中国网络资本支出长期领先,基站数量、网络覆盖全球最广。这为应用创新创造了充分的试错空间,字节跳动、小米、美团、滴滴、小红书等一代创新企业快速成长。

随着产业轮动,算力正在变成新一代基础设施。他的现实担忧是,国内 AI 创业公司如智谱、DeepSeek 等,和 OpenAI、Anthropic 等 AI 创业公司企业的收入估值等差距在拉大。美国市场,一批百亿美元、千亿美元估值的 AI 创新企业正在批量诞生。在他看来,中国算力未来五年至十年的长期竞争力,决定性因素不仅在于芯片、算法、能源、应用的系统优化能力,更在于能否创造创新土壤,孕育出新一代创新企业。

与上述观点不同,另一位通信与 ICT 产业资深技术人士的看法是,基础设施与应用创新之间,不是简单的线性关系。中国市场 4G 时代移动互联网集中爆发,不只是因为网络建设本身,更是因为移动手机普及、互联网应用创新、互联网商业模式逐渐清晰等多重因素在同一时间点汇聚。他认为,算力不是最终目的,算力、应用供需平衡且同频共振才是关键。

回顾上一轮移动互联网的创新周期,3G-5G 移动基础设施的价值,不只是 “修好了一条宽阔大路”,它更是系统性地降低了应用创新和获取用户的门槛。移动应用带来的巨大流量与数据,又反过来带动了网络扩容、云服务增长和终端性能升级,商业价值因此完成了闭环。中国不只培育了全球最庞大、最活跃的移动用户群体,还催生了若干全球知名的科技巨头,更是在零售、支付、出行、文娱等多个行业带来了市场创新。

上述两位产业资深人士的共同看法是,在芯片受限、资本规模存在差距的背景下,中国算力的关键不在于是否拥有更多算力资源,而在于能否让算力被真实应用、持续使用,并最终形成可验证、可持续的商业回报。

算力只有真正被使用,才是生产力。算力的竞争,最终不是资源规模的竞赛,而是创新能否发生,发生在哪里,是否被市场持续放大的问题。

风险提示及免责条款

市场有风险,投资需谨慎。本文不构成个人投资建议,也未考虑到个别用户特殊的投资目标、财务状况或需要。用户应考虑本文中的任何意见、观点或结论是否符合其特定状况。据此投资,责任自负。