欧盟 AI 法案出炉 全球领先的 AI 模型均不及其监管要求

按照歐盟草案中的 12 條規則,表現最好的 AI 模型在 48 分的總分中只得到了 36 分,ChatGPT 得分 25,谷歌支持的 Anthropic 模型也只有 7 分。

備受矚目的歐盟人工智能監管法案(EU AI Act)正在走向收尾階段。自去年底 ChatGPT“一夜成名”,AI 迎來狂飆時刻,各種新應用新模型層出不窮,監管呼聲也日益高漲。歐盟 AI 法案監管的跨邊境特徵——只要是在歐盟市場投入服務或部署 AI 系統的企業都將受到監管,無論其是在歐盟內部還是第三國,以及考慮到這是全球首個試圖全面監管 AI 的嘗試,歐盟 AI 法案成為各方關注的焦點,6 月 14 日歐盟議會通過該草案後,主席羅伯塔·梅佐拉 (Roberta Metsola) 即表示,這項法案 “毫無疑問將在未來數年成為全球標準”。

不過該法案還遠未能落地,不僅是因為這是個極其複雜的嶄新領域,涉及監管與創新的平衡、對社會和經濟的長遠影響等,還因為歐盟的法律生成程序異常繁雜,且仍面臨着來自成員國、企業等多方的政治博弈。

歐盟 AI 監管法案有哪些核心內容?對企業影響幾何?多久才能落地,以及未來可能還會如何演變?

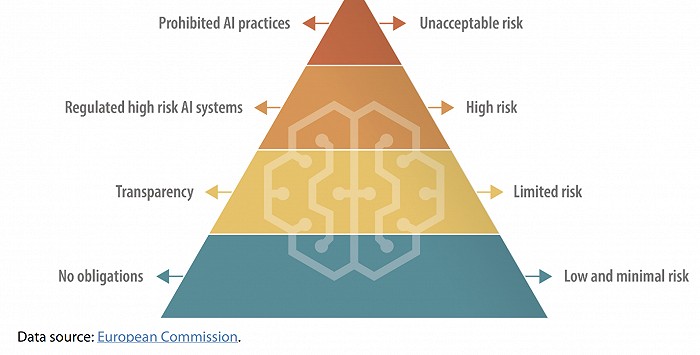

“風險金字塔”

該法案的基石是一套對不同 AI 應用風險等級判定基礎上的風險分類體系,風險體系被分為四等,從高到低分別為,“不可接受的風險”、“高風險”、“有限風險”、“低風險和極小的風險”。針對不同等級的風險,實施不同程度的限制措施。

1. 不可接受的風險,指的是可對人們的安全、生計和權利構成明顯威脅的行為。包括:

—對普通人或特定羣體實施認知行為操縱,比如,鼓勵兒童危險行為的發聲玩具。

—社會評級:基於行為、社會經濟地位或個人特徵對人進行分類。

—實時和遠程生物識別,比如面部識別系統。此條也有例外情形,不過條件嚴苛——遠程的生物識別,且距離識別行為發生後很長一段時間(after a significant delay),可在獲得法庭許可後用於對嚴重犯罪行為的起訴中。

帶有不可接受風險的 AI 系統、產品等將被明確禁止在歐盟市場上銷售和使用。

2. 高風險,指能對人們的安全或基本權力產生不利影響的行為,主要涉及兩類:

—在歐盟產品安全法律條文下受監管的玩具、航空、汽車、醫療設備、電梯等所使用的 AI 系統;

—以下需要在歐盟數據庫登記備案的八類 AI 系統:

- 針對自然人的生物識別和分類;

- 關鍵基礎設施的管理和運營;

- 教育和課外培訓;

- 就業,工人管理和自僱相關的機會;

- 關鍵私人服務、公共復甦和利益的獲得和享受(access to and enjoyment);

- 執法領域;

- 移民、難民和邊境管理;

- 為法律解釋和法律使用提供協助。

所有高風險的 AI 系統在投入使用前以及其整個生命週期中都需要接受評估。

3. 有限風險的 AI 系統:這些系統對人們的安全或基本權利的影響較小,因此需要滿足的義務主要是透明度要求。

4. 低或最小風險的 AI 系統:這些系統對人們的安全或基本權利的影響非常有限,因此不需要特別的監管要求。

另外,該法案也覆蓋了對通用模型的監管。按照歐盟議會的草案,通用人工智能的大模型提供者(不是部署者)需要在透明度、數據管理、風險消減和登記註冊等方面滿足監管要求。

該草案還附帶了處罰條款,若違反可能面臨高達 4000 萬歐元或相當於公司全球一年營收額 7% 的罰款。

達不到的監管要求?

當下企業能否滿足歐盟的監管要求?答案恐怕是否定的。

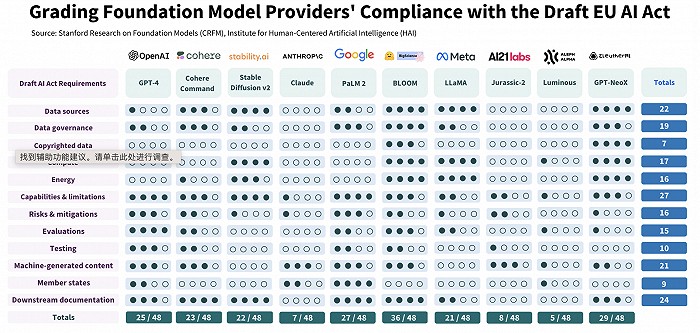

斯坦福大學近日公佈的一項研究結果表明,迄今為止,有 AI 基礎模型部署的全球領先的 AI 公司距離滿足歐盟的監管要求還有很遠的距離。

研究者們選定了歐盟草案中的 12 條規則,然後逐一逐項為全球 10 個領先的 AI 模型打分,結果顯示,其中表現最好的(Hugging Face 的 BLOOM)在 48 分的總分中也只得到了 36 分。佔據市場領先地位的 ChatGPT,其表現只能算中等,得分 25。最低的分數只有 5 分,來自德國一家 AI 公司 Aleph Alpha,而谷歌支持下的 Anthropic 模型得分也只有 7 分。

研究者認為透明度欠缺是目前大模型在監管合規上的主要障礙。“基礎模型提供者在數據、計算和模型部署,以及模型本身的關鍵特徵方面,極少透露精確信息,” 他們在報告中寫道。他們的評估也顯示,滿足對歐盟 AI 監管草案的要求對這些基礎模型提供者是可行的,首要任務就是要增強透明度。

一直以來,主要 AI 公司均表示支持對 AI 行業進行監管,不過在如何監管上仍存在分歧。OpenAI 的創建者 Sam Altman 據報道過去一個月一直在全世界各地會見各國政府監管機構,在各種公開場合呼籲對 AI 進行全球性監管,不過從《時代週刊》拿到的文件來看,OpenAI 正在遊説在歐盟 AI 法案中增加補充條款,減輕公司的監管負擔。

值得一提的是,最近歐盟議會以絕對優勢通過 AI 草案並不意味着歐盟的 AI 監管措施正式落地。14 日的歐盟議會投票只是意味着,繼歐盟委員會和歐盟理事會之後,歐洲三大核心監管機構中的第三個,加入到了 AI 監管法案的談判場。在接下來的 “三方會談(trilogue)” 階段,三大機構的決策者以及歐盟各成員國將就法案的最終細節進行協商然後投票。布魯金斯學會預計,考慮到 AI 法案已被列為政治優先事項,“三方會談” 預計進展會非常迅速——歐盟委員會希望能在今年底完成對 AI 法案的投票,力爭不對明年 6 月的歐盟議會選舉產生政治影響。

國際律所 Gibson Dunn21 日刊文稱,如果今年底完成 “三方會談”,敲定最終版本,那麼這個 AI 法案將進入為期兩年的執行期(implementation period),在這期間,相關治理架構,比如歐盟人工智能辦公室(the European Artificial Intelligence Office)將建立起來,並最早將於 2025 年下半年向所有 AI 提供商和部署商提供服務。

博弈仍將繼續

歐盟 AI 法案接下來如何演變,“三方會談” 中的博弈將是關鍵。麻省理工科技評論 19 日刊發的一篇文章列出了草案中的五個最應該關注、最可能成為博弈焦點的地方:

第一,禁止情緒識別 AI 系統。歐盟議會的草案禁止在警局、學校和工作場合使用試圖識別人們情緒的 AI 系統,比如,判斷一個學生是否能理解學習內容,一個正在駕駛汽車的司機是不是會睡着等。此前歐盟理事會和歐盟委員會通過的草案中沒有這一禁令,意味着這一點可能會成為 “三點會談” 中博弈的焦點之一。

第二,禁止在公共場所進行實時生物識別和預測性執法(predictive policing)。如何執行將是個難題,而且一些成員國認為,生物識別是現代警務工作中所必需的,比如法國,實際上正在計劃增加對面部識別的使用。

第三,禁止社會打分(social scoring)。公共機構進行的社會評分,或利用人們的社會行為數據進行歸納和描述的做法,將被取締。在一些國家,通過社會行為數據來評估發放抵押貸款、設定保險費率、招聘員工等做法很常見。但在歐盟,這些行為將受到限制。

第四,對通用人工智能的新限制。該草案首次提出了規範生成性人工智能的方法,並禁止在 OpenAI 的 GPT-4 等大型語言模型的訓練集中使用任何受版權保護的材料。該法案草案還要求對人工智能生成的內容進行標示。這也意味着,歐洲議會現在必須向歐盟委員會和各個國家推銷其政策,這些國家可能會面臨來自科技行業的遊説壓力。

第五,對社交媒體上的推薦算法的新限制。新的草案將算法推薦系統歸入 “高風險” 類別,這是在其他擬議法案基礎上的升級。這意味着,如果該法案通過,社交媒體平台上的推薦系統將受到更多審查,科技公司可能要為用户生成的內容承擔更多責任。

本文作者:閆桂花、車念聰,來源:界面新聞,原文標題:《歐盟 AI 法案出爐,OpenAI 等公司可打幾分,核心爭議點有哪些?》