OpenAI 新產品 GPTBot:可爬取網絡數據,為 GPT-5 做準備

OpenAI 稱,GPTBot 抓取的海量數據將用於訓練、優化未來模型,有海外媒體指出,這個 “未來模型” 指的就是 GPT-5。

8 月 8 日,OpenAI 在官網介紹了新產品 GPTBot,這是一種網絡爬蟲,可大規模爬取網絡數據用於訓練 AI 模型。(地址:https://platform.openai.com/docs/gptbot)

OpenAI 表示,將通過 GPTBot 抓取海量數據,用於訓練、優化未來模型。國外不少科技媒體指出,這個未來模型指的就是 GPT-5。

事實上,OpenAI 在今年 7 月 18 日提交了 GPT-5 商標的消息,此時又放出全新網絡爬蟲, 説明 GPT-5 離我們越來越近了。

GPTBot 介紹

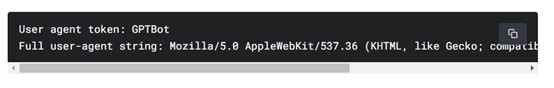

GPTBot 是 OpenAI 的網絡爬蟲,可以通過以下用户代理和字符串來識別,代碼如下。

User agent token: GPTBot

Full user-agent string: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; GPTBot/1.0; +https://openai.com/gptbot)

OpenAI 會對抓取的數據進行過濾,例如,刪除需要付費才能查看、使用的數據,蒐集的個人身份信息(PII)或違反法律法規的數據等,以保證抓取的數據符合安全標準。

如果用户的網站不想被 GPTBot 抓取數據,可以將 GPTBot 添加到站點的 robots.txt 中,代碼如下:

User-agent: GPTBot

Disallow: /

用户也可以自定義 GPTBot 的訪問權限,將其添加到網站的 robots.txt 中,代碼如下:

User-agent: GPTBot

Allow: /directory-1/

Disallow: /directory-2/

什麼是網絡爬蟲

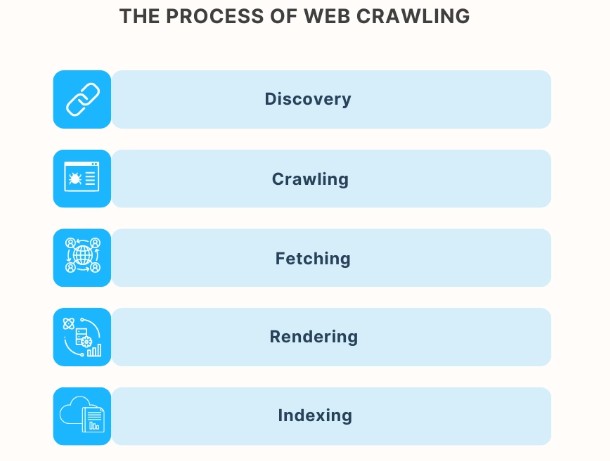

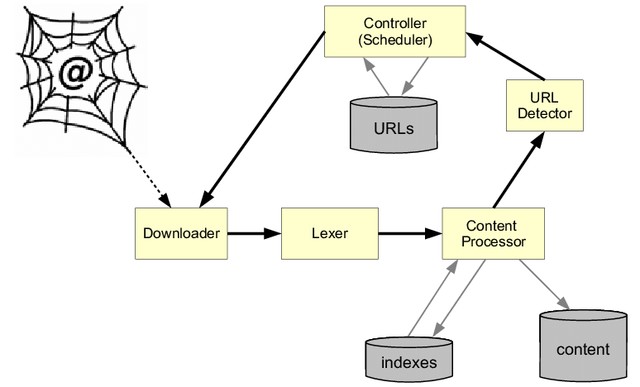

網絡爬蟲,是一種主要通過瀏覽網絡抓取數據的工具,方式包括數據挖掘,網頁數據複製/拍照、網站鏡像等方式。

網絡爬蟲是互聯網和大數據時代最重要工具之一,被譽為 “黃金礦工” 應用場景非常廣泛。

例如,谷歌、百度等搜索引擎通過網絡爬蟲來收集和建立網頁索引,方便用户可以通過關鍵字快速找到相關的網頁。

也有商業機構使用網絡爬蟲實時收集競爭對手的信息,如產品價格、新產品發佈、營銷活動等,以進行市場分析和營銷策略制定。

網絡爬蟲的缺點

雖然網絡爬蟲功能強大,但也存在數據質量不穩定、版權風險、難以爬取特定內容、爬取頻率等缺點。

數據質量不穩定:網絡爬蟲抓取的數據可能包含大量非法、虛假或質量低下的數據,例如,爬取了一個非法網站的數據。因此,想使用爬蟲的數據需要進行清洗和處理。

版權風險:網絡爬蟲可能會侵犯數據隱私和版權,違反網站的使用協議帶來法律風險。例如,非法爬取了目標網站的付費內容。

難以爬取特定內容:對於一些需要用户輸入或交互才能獲取的內容,例如,網站搜索結果、驗證碼、登錄後才能查看的內容等,網絡爬蟲可能難以抓取。

爬取頻率:網絡爬蟲抓取的數據是靜態的,不能實時反映網頁的變化需要定期重新抓取。但頻率過高會對目標網站的服務器造成巨大壓力影響其正常服務,頻率太低數據更新又不及時,需要制定一個合理的頻率。

如今在大模型等 AI 技術加持下,上述常見的網絡爬蟲缺點已得到克服,並且更注重數據版權、安全等問題。

網絡爬蟲抓取的數據,是訓練大語言模型的重要來源

目前,訓練大語言模型的主要數據來源包括自有數據集、開源數據集和網絡爬蟲等。自有數據集主要應用在特定業務場景的微調,例如,法律領域的使用真實的法律裁決、書籍、法律合同等數據,訓練專用於法律的生成式 AI 產品。

開源數據集,這種數據是很多大型廠商開源的數據有的可用於商業化,有的只能用於技術研究,並且數據可能存在老舊的情況。所以,網絡爬蟲成為企業訓練通用大模型的重要數據來源。

例如,OpenAI 的 GPT-3 模型使用了 45TB 的互聯網文本進行訓練,包括代碼、小説、百科、新聞、博客等,而這些數據來源多數是通過網絡爬蟲獲取。

所以,我們有時候會看到 ChatGPT 會生成虛假的信息,就是因為在爬取時本身就抓取了錯誤、虛假的信息,在清洗、預訓練、微調的過程中又沒發現,才會出現這樣的情況(有時也存在 AI 算法問題等)。

不過 OpenAI 已經制定了嚴格的數據獲取、使用標準,避免這種情況發生。

本文來源:AIGC 開放社區,原文標題:《OpenAI 新產品 GPTBot:可爬取網絡數據,為 GPT-5 做準備》